企业 | 安森美亮相北京听力学大会,展示智能听力技术

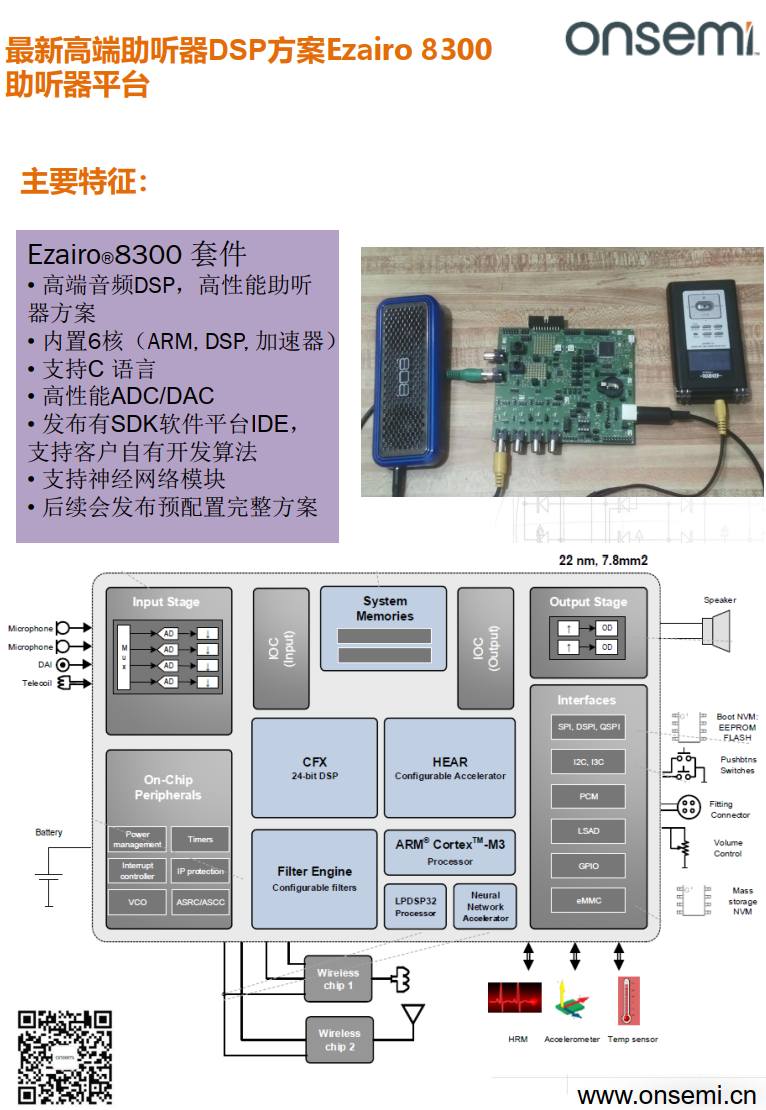

安森美重点展示了Ezairo系列平台——搭载人工智能增强处理器和先进的神经网络能力,专为高性能助听器及高端音频设备设计。

助听器

安森美 . 2025-06-20 1 1 1115

产品 | 开启游戏新时代:NVIDIA 实现神经网络渲染技术的突破性增强功能

近日,NVIDIA 宣布了 NVIDIA RTX™ 神经网络渲染技术的突破性增强功能。NVIDIA 与微软合作,将在 4 月的 Microsoft DirectX 预览版中增加神经网络着色技术,让开发者能使用 NVIDIA GeForce RTX™ GPU 中的 AI Tensor Cores,在游戏的图形渲染管线内加速神经网络渲染。 神经网络着色是图形编程的一场革命,将 AI 与传统渲染相

NVIDIA

NVIDIA英伟达 . 2025-04-03 1 1440

N1家族又添新成员!安霸N1-655,功耗低于20瓦,支持本地多个通道的VLM和神经网络并行处理

新款 AI SoC 是本地部署AI盒子、具身智能机器人和智慧城市应用的理想之选;其高性能、低成本突破了前端 AI 应用的功耗和成本瓶颈 美国加利福尼亚州圣克拉拉市,2025年1月7日- Ambarella(下称“安霸”,纳斯达克股票代码:AMBA,AI 视觉感知芯片公司)在 CES 上发布了 N1-655 前端生成式 AI 芯片(SoC),该芯片可同时处理 12 路 1080p30 视频解码

安霸

Ambarella安霸半导体 . 2025-01-09 3690

STM32全球在线峰会:揭示2024年嵌入式系统三大趋势

ST于3月19日成功举办STM32全球在线峰会,不仅让业界了解到影响行业发展趋势的新技术,还与大家共同展望了2024年这些新技术将把产业带向何方。

STM32

意法半导体博客 . 2024-04-17 1 3735

多深度神经网络的调度机制研究

自动驾驶系统依赖于人工智能深度神经网络(deep neural networks, DNN)算法来执行感知、决策和控制等复杂任务。 近年来,针对于自动驾的深度神经网络算法的精度有了显著提高。然而,汽车在行驶过程中,除了要保证自动驾驶系统的输出和决策是准确的之外,其时机也必须是确定性的,因为即使准确但过晚的输出可能导致汽车撞上障碍物从而发生事故。因此准确性和实时性都是安全系统中需要考虑的关键

深度神经网络

TechSugar . 2023-01-30 2559

【自适应计算在机器人领域的应用】连载一:什么是自适应机器人?

作者: Víctor Mayoral-Vilches 和 Giulio Corradi,赛灵思公司 连载一:什么是自适应机器人? 机器人是一种系统级的系统,它由感知周边环境的传感器、根据感知采取行动的致动器和负责处理数据的计算构成,用于对其应用做出连贯一致的响应。在很大程度上机器人技术是一种系统集成的艺术,从软件的角度和硬件的角度看皆是如此。以往的研究揭示,在机器人领域中多达 70%

神经网络

厂商供稿 . 2021-11-11 2064

首届RISC-V中国峰会即将举行 汇集最新技术和学术成果

中国上海,2021年5月27日 – 首届RISC-V中国峰会(RISC-V World Conference China)将于6月21日在上海科技大学盛大开幕。本次峰会预计线下超过1000人、线上超过10000人参会,超过100家厂商进行演讲或参展,将会成为国内迄今为止规模最大的以RISC-V为主题的峰会。这也是RISC-V第一次在北美以外地区举办同等规模的峰会。其中主会将举办三天半(6月22日至

NPU

厂商供稿 . 2021-05-31 1970

Maxim Integrated宣布与Aizip达成合作,为业界提供最低功耗的IoT人形识别方案

MAX78000 AI微控制器与Aizip的视觉唤醒词模型相结合,将人形检测引入IoT图像和视频应用,每次推算仅消耗0.7 mJ-------功耗降低100倍! 中国,北京 – 2021年4月22日 –Maxim Integrated Products, Inc (NASDAQ: MXIM)与专注于物联网(IoT)领域人工智能(AI)技术开发的Aizip公司达成合作,Maxim Integrate

智能视觉

厂商供稿 . 2021-04-25 1630

【书讯】非线性微分系统的控制算法及应用

《非线性微分系统的控制算法及应用》 作者:张群力 著 出版日期:2020年10月 开本:16开 出版社:经济管理出版社 《非线性微分系统的控制算法及应用》阐述了近十几年来控制领域中控制器的设计和算法推导问题,包括非线性微分系统迭代学习控制、线性矩阵方程的迭代求解、非线性微分系统的脉冲控制及间歇控制、算子梯度法设计控制器等。 《非线性微分系统的控制算法及应用》中既注意算法推导的实用性,又注意理论分析

算法

中国经济学人官微 . 2021-02-26 840

利用神经网络法实现对焦平面非均匀性校正进行改造设计

红外焦平面探测是一种兼具辐射敏感和信号处理功能的新一代红外探测技术,但是由于制造过程和工作环境的影响,使得焦平面阵列(FPA)各个阵列元即使在相同的辐射通量照射下,也会输出不相同的响应电压。这种红外响应引起的遥感图像的失真被称作红外图像的非均匀性。为了提高观测频率、扫描范围和空间分辨率,航天遥感一般采用推扫式的多元敏感线阵列对地物成像,通过观察发现,推扫得到的遥感图像出现有规律的条带失真,条带宽度

探测器

电子设计应用 . 2021-01-12 1255

谷歌“升维打击”:还原任意角度光照立体效果,2D变“4D”

贾浩楠 发自 凹非寺 量子位 报道 | 公众号 QbitAI 2D变3D,还不用建模,今年谷歌用NeRF做到了以假乱真的程度: 感觉就像是视频里截出来的是不是?神经网络只需要几张静态照片就能生成这样的结果。 但,总感觉离真实的场景还差点什么? 没错,缺的就是光影变换效果,NeRF只高度还原了空间,没有给人时间上的直观感受: 上面的结果,同样是用几张2D照片作为输入,但有实时光影效果的生成结果,更加

谷歌

量子位 . 2020-12-27 805

张量计算在神经网络加速器中的实现形式

引言 神经网络中涉及到大量的张量运算,比如卷积,矩阵乘法,向量点乘,求和等。神经网络加速器就是针对张量运算来设计的。一个神经网络加速器通常都包含一个张量计算阵列,以及数据收发控制,共同来完成诸如矩阵乘法,卷积等计算任务。运算灵活多变的特性和硬件的固定架构产生了矛盾,这个矛盾造成了利用硬件执行计算任务的算法多变性。不同的硬件架构实现相同的计算,可能具有不同的算法。我们今天讨论基于脉动阵列的计算架构,

fpga

AI加速微信公众号 . 2020-11-02 1185

科大讯飞将以技术进步来驱动AI的持续发展

10月23日,在2020科大讯飞全球1024开发者节上,科大讯飞董事长刘庆峰就公司未来发展谈了自己的看法。 他说:“现在所有的发展都离不开核心技术的持续进步和推动,全球的技术竞争格局,也进一步倒逼在源头创新上做更好的布局,带着更大的梦想面向未来。”他进一步指出,科大讯飞未来会以技术进步来驱动AI的持续发展,具体包括算法突破重点、技术赋能数字和前瞻研究三个大方向。 其中算法突破重点方向主

神经网络

人工智能实验室 . 2020-10-30 1575

如何评价现在的人工智能技术

人工智能:现在的人工智能应用,简答来说就是“弱人工智能”也被称为,应用人工智能,它通常包含语言处理、视觉处理、语音识别等。 怎样评价现在的人工智能技术? 就好比一个人类出生有一段婴儿期,像目前人工智能智能就处于三到四岁的婴儿一样,他只能不断的深入学习。 谷歌(AlphaGo)以4比1的总比分获胜、第一个战胜围棋世界冠军 的人工智能机器人 主要工作原理是不断的“深度学习 “。”深

神经网络

拓世智能 . 2020-10-16 1550

机器学习模型:感知器的诞生及具体算法

各位小伙伴们,又到了喜闻乐见的更新时间,最近猛料不断,先有Boston动力的“仁义”机器人反恐演习,紧接着MIT的狗狗们在实验室的绿茵场上集体卖萌,让我们感慨强人工智能离我们也许不远了。 作为快要秃头的我们,又该怎么看待这个快速变化的世界呢?在知识更新越来越快的现在,想要专注于当下似乎都变得艰难。其实柳猫想要告诉大家,作为一个普通人,对各种信息越是了解的多,认识的越是浅薄,为了增强自己的不可替代性

神经网络

itpub技术栈 . 2020-09-29 1100

面向未来的AI加速, ACAP可编程器件具有突破性意义

作者:Mike Thompson,赛灵思 Virtex UltraScale+ FPGA 与 Versal Premium ACAP 高级产品线经理 AI 无处不在、随时在线和以数据为中心的时代,正催升对更高带宽的需求,而这已经超出了当今技术和产品尺寸的能力范畴,世界需要一种当前 CPU 和 GPU 技术所无法企及的更高效、更普及、普适的计算,自适应计算应运而生。 AI无处不在,随时在线和以数据为

fpga

Xilinx赛灵思官微 . 2020-09-28 2185

我国首台基于自主知识产权类脑芯片的类脑计算机研制成功

近日,浙江大学联合之江实验室,共同研制成功了我国首台基于自主知识产权类脑芯片的类脑计算机。 这台类脑计算机包含792颗浙江大学研制的达尔文2代类脑芯片,支持1.2亿脉冲神经元、近千亿神经突触,与小鼠大脑神经元数量规模相当,典型运行功耗只需要350~500瓦,同时它也是目前国际上神经元规模最大的类脑计算机。 与此同时,团队还研制了专门面向类脑计算机的操作系统——达尔文类脑操作系统,实现对类脑计算机硬

计算机

中国科学报 . 2020-09-09 1210

MCU如何在边缘和节点设计中实现AI功能

AI:Artificial Intelligence,即人工智能。 AI与我们息息相关,手机导航、语音控制、智慧工厂、物流等这些都会运用AI相关技术。 随着人工智能的普及,很多使用MCU开发的产品也走向了AI的世界。AI设计主要参与方都是功能强大的CPU,GPU和FPGA等。MCU与强大的人工智能(AI)有什么关系? 随着AI从云到边缘的发展,使得这一观点正在迅速改变,AI计算引擎使MCU能够突破

智能建筑

玩转单片机 . 2020-08-19 2105

研究人员研发新型基于人脑的算法,可帮助神经网络节省内存

如今,人工智能的发展如火如荼,广泛应用到了图像、自然语言、人机对话等各个领域,对各个产业进行了变革。 在移动应用中,人工智能广泛使用的最大障碍之一是人工神经网络的学习活动需要消耗大量能量,而解决这一问题的一种方法可以从大脑中获得灵感。这是因为大脑具有超级计算能力,而且大脑神经元之间可以通过短的电脉冲或尖峰进行有效传输,极大节省了能量。 基于此思路,奥地利格拉茨工业大学的研究人员 Wolfgang

人工智能

钛媒体APP . 2020-08-17 1510

FPGA中使用FP16格式的点积运算实例分析

Achronix资深现场应用工程师,杨宇 神经网络架构中的核心之一就是卷积层,卷积的最基本操作就是点积。向量乘法的结果是向量的每个元素的总和相乘在一起,通常称之为点积。此向量乘法如下所示: 图1 点积操作 该总和S由每个矢量元素的总和相乘而成,因此S=a1b1+a2b2+a3b3+···anbn 本文讲述的是使用FP16格式的点积运算实例,展示了MLP72支持的数字类型和乘数的范围。 此设计实现了

MLP

Achronix . 2020-08-15 1610

- 1

- 2

- 3

- 4

- 5

- 6