早在2010年,NVIDIA在GTC会议上提出将GPU用于通用计算的想法,聚焦超级计算机并在十多年来一直在强化加速计算技术的地位,时至今日,其在加速计算领域具有丰富的经验和技术优势,使其在短期内很难被竞争对手超越。

随着生成式AI应用持续发酵,AI加速和高性能计算芯片市场将在未来几个季度快速发展,GPU已经从原本主要用于图形渲染和游戏领域,进一步扩展到高性能计算、数据中心以及人工智能训练与推理等更广泛领域。在这个趋势的推动下,NVIDIA的竞争对手们并不会止步不前,其中也衍生出非GPU类型的AI芯片。

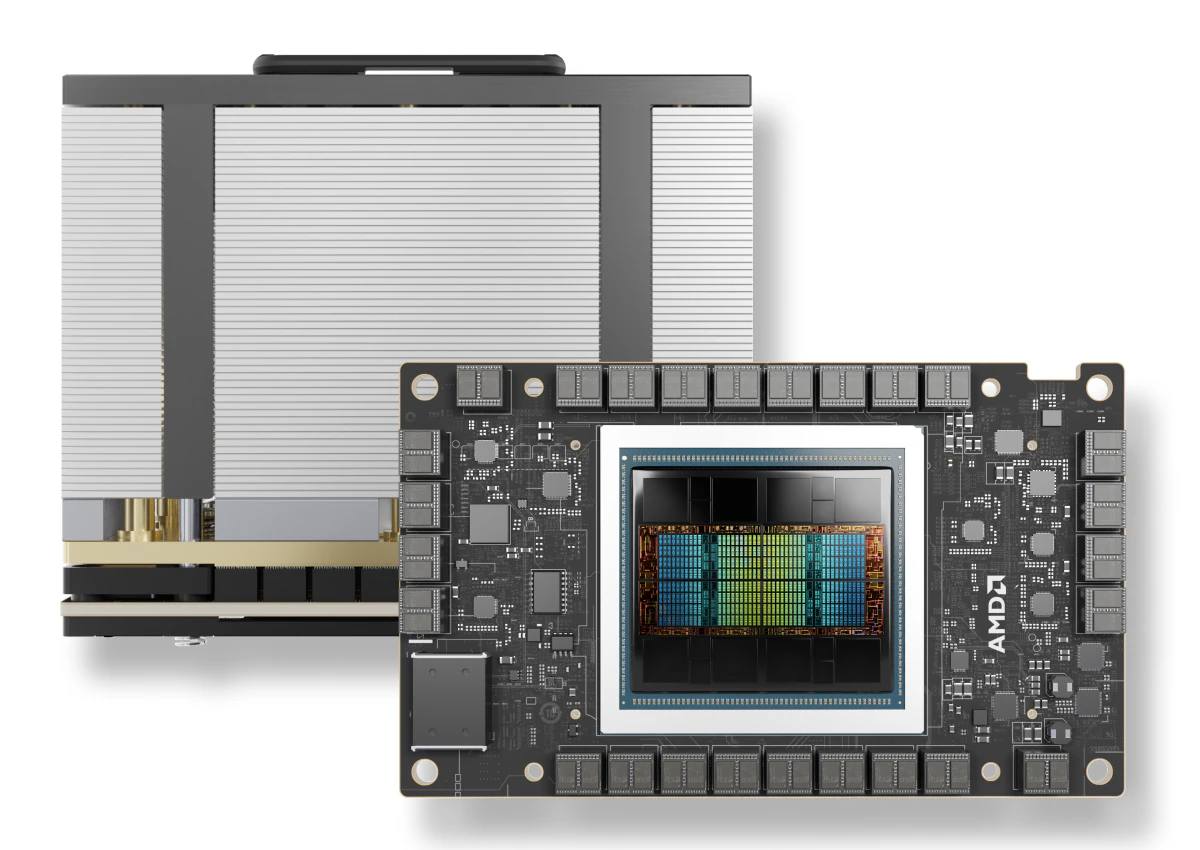

MI300X开始出货,AMD与NVIDIA的差距或缩小

早在去年12月AMD推出MI300X的时候,就表明该产品对标NVIDIA H100,此后双方推出各自的基准测试,至今H100或MI300X谁更强没有定论。但比较肯定的是,AMD是目前能够在AI领域与NVIDIA相抗衡的比较有实力的厂商,两家公司都拥有非常强大的AI解决方案。

图注:AMD Instinct MI300X加速器设计用于生成式AI和HPC应用(图源:AMD)

1月22日消息,AMD开始量产MI300X,并率先交付合作伙伴LaminiAI,后者将采用MI300X运行大型语言模型(LLM),并表示已经收到了多台配备8个Instinct MI300X加速器的机器,LaminiAI下一批LLM集群即将上线。除了LaminiAI,Meta和微软也已采购大量AMD Instinct MI300系列产品。

MI300X是AMD Instinct MI300系列的高性能版本,面向AI和HPC计算,放弃使用x86 CPU内核,搭载更多CDNA 3计算单元(AMD专用计算架构),总数达到304个,远高于MI300A的228个,并配备192GB HBM3高速内存,峰值带宽高达5.3TB/s。AMD官方性能测试显示,MI300X的表现优于市面上的NVIDIA H100 80GB。

AMD作为NVIDIA的主要竞争对手,在CPU市场取得突破后,也在GPU领域发力,特别是在其RDNA和CDNA架构上投入大量研发资源,提升对AI应用的支持。AMD基于开源项目的GPU计算生态系统ROCm(Radeon Open Compute)平台是其对抗CUDA的重要武器,旨在提供一个开放且跨平台的高性能计算环境,支持多种AI框架。此外,AMD还通过收购开源AI软件公司等举措,增强自身在AI领域的软硬件一体化方案,缩小与NVIDIA在生态上的差距。

云服务商的利润被NVIDIA蚕食,谷歌是个例外

有分析指出,以GPU服务器的价格可以购买10台或更多CPU服务器,而GPU服务器90%利润归NVIDIA。例如英特尔获得了NVIDIA GPU DGX-H100的合同,虽然系统可以同时配备英特尔最昂贵的两颗CPU,但这对英特尔业绩没有多大帮助,NVIDIA甚至从英特尔客户获得收益,同样的情况也发生在亚马逊之类的云服务商。

图注:AMD、NVIDIA、英特尔3家公司在数据中心市场的份额

图注:亚马逊云服务AWS花了6年时间才将其营业利润率从24%提高到32%,而NVIDIA花了一年时间使其利润下滑

谷歌却是一个例外。与竞争对手一样,谷歌云服务器也采用NVIDIA H100 GPU,但区别是,谷歌还有自己的张量处理单元(Tensor Processing Unit,TPU),这是一个专门用于矩阵乘法的非GPU硬件。

图注:图例为谷歌TPU v5e的集群配置

谷歌对人工智能的野心由来已久,但也面临着同样的问题:NVIDIA GPU购置和大规模部署成本很高,这是谷歌定制硅芯片TPU的原因。与许多AI加速器类似,TPU浮点矩阵乘法数学的一种解决方法,但是相比GPU,可以较低精度换取更低成本。大量研究表明,使用GPU获得的高精度计算能力在多数应用中都被浪费。

所有谷歌AI服务,包括搜索、广告、地图、YouTube等都在TPU上运行,这对谷歌是一个很大的成本优势。

TPU可以被视为ASIC(专用集成电路),但更确切地说是“AI加速器”。TPU v1于2016年问世,仅供谷歌内部使用。TPU v2-4也都可以在谷歌云服务上使用,新产品版本是v5e。TPU v1-4是针对谷歌内部需求设计,TPU v5e在设计时考虑了云服务客户的需求。TPU v4芯片在部署中的数量为4k颗,v5e将可拓展到数万颗,允许数据中心在TPU上训练比以前更大的语音模型,支持多达两万亿个参数和GPT-4。每颗v5e芯片获得的性能与v4相近,具体取决于工作负载,但成本低、效率高。粗略估计,相同计算任务下,基于TPU v5e的谷歌云服务比H100节省40-70%成本。

图注:TPU v5e与TPU v4运行不同大模型的性能和成本

软件是NVIDIA的护城河,NVIDIA自2005年以来一直在构建软件工具来训练模型,并在生产中运行它们。尽管现有以及即将推出的AI加速器能够以远低于NVIDIA GPU的成本完成相同的任务,包括TPU v5e的后来者都在实际应用中面对软件的问题。

因此,TPU v5e服务器集群配置更突出的是成本以及设备连接的难度,TPU v5e优势之一是在设计的时候就考虑到整个数据中心的构建。例如,一个数据中心大约有128个单元,总共有33k颗芯片,可以将整个数据中心租赁给客户用于一项计算任务。值得注意的是,TPU芯片由博通设计、台积电制造。

博通:容易被忽略的玩家

在早期,博通曾参与谷歌TPU芯片的设计与制造过程,但2023年谷歌与博通的关系似乎经历了一段时间的波动,有传闻指出谷歌考虑放弃与博通在TPU芯片上的合作,因为双方在芯片定价和商业条款上出现了分歧,但在2027年之前,谷歌与博通的关系不会发生大改变。

这将有利于博通的业绩,虽然博通大部分业务面向的是目前疲软的智能手机和PC市场,人工智能在未来一个季度仍然是博通业务的增长点。通过几次收购,博通现在也拥有庞大的软件部门,收购VMWare之后,软件部门可能会变得更大。

在数据中心领域,博通比其他竞争对手的情况更好,原因是其与谷歌的关系,以及软件业务的周期性低于硬件。挑战在于,第一,双方是否签订TPU v5硬件合同,第二,TPU赶上并开始取代GPU是一个艰难的过程,第三,谷歌云与亚马逊的云计算部门亚马逊网络服务(Amazon Web Services,简称AWS)的AI基础设施一样配备了流行的开源软件工具,可作为服务使用,但这还不够,与NVIDIA相匹配的软件堆栈是关键,如果谷歌能解决这个问题,对博通是利好。

图注:博通与Marvell的营收对比(数据来源:YCharts)

亚马逊展示新款AI处理器

AWS去年11月展示了2款用于训练人工智能模型的处理器,新款Graviton4和Trainium2比前一代具有更多内核和内存:Graviton4性能比Graviton3高30%,内核增加50%,内存增加75%。

亚马逊声称,Trainium2的训练速度比第一代快四倍,将用于AWS的EC2 UltraClusters,最多容纳10万颗芯片,能在“很短的时间内”训练基础和大型语言模型(LLM),并将能源效率提高两倍。Graviton4则是AWS五年内交付的第四代产品。使用新芯片的AWS客户包括Anthropic、Databricks、Datadog、Epic、Honeycomb和SAP。

此外,AWS和NVIDIA扩大了之前的协议,将通过NVIDIA DGX Cloud在AWS上提供H200 AI GPU。AWS表示还将提供第一台具有NVIDIA Grace Hopper超级芯片和AWS UltraCluster可扩展性的云AI超级计算机。

英特尔:“门口的野蛮人”

英特尔推出了其Core Ultra芯片(代号“Meteor Lake”)的推出,产品方向是人工智能,同时推出的产品还有面向服务器和数据中心的第5代Xeon CPU,2款芯片都提供AI加速。

Core Ultra将多项关键新技术和功能整合到一个SoC中,显著变化是首次集成NPU(神经处理单元),NPU负责加速AI工作负载,释放CPU和GPU执行其他任务,目标是使PC运行新的应用,提高电池寿命和整体效率,这是AI PC时代的早期产品。AMD也有内置NPU的PC芯片Ryzen 7040,更新的是Ryzen 8040。

Core Ultra结合多达6个高性能P核和8个注重效率的E核,而且还包括两个新的超低功耗内核,称之为低功耗岛,可以在系统需求较低时启动。Core Ultra中的新GPU基于该公司的独立Arc芯片,提供多达8个Xe图形内核,与之前的英特尔集成显卡解决方案相比,性能提高了2倍。

迄今为止,业界关注点都集中在NPU的TOPS(每秒万亿次操作)参数上:高通特别强调了其即将推出的Snapdragon X Elite将如何拥有45 TOPS的NPU(系统TOPS性能为75);英特尔NPU在Meteor Lake中的原始TOPS性能为10;AMD锐龙8040中的TOPS性能应该是16。英特尔和AMD都专注于系统TOPS,CPU和GPU性能都将影响这些数字,英特尔声称Core Ultra的系统TOPS高达34,AMD的8040系统TOPS高达39。

任何形式的TOPS数字,真正价值都存在着行业争论,尤其是对于NPU而言。在实际使用中,以人工智能为中心的应用已经使用CPU和GPU,随着时间的推移增加对NPU的支持。

仅利用NPU的应用并不多,因此TOPS性能基准测试的当前实际价值有待商榷。现在在PC上完成的许多与AI相关的工作都是通过云完成的,并且不进行任何本地处理,包括ChatGPT、Microsoft 365等。

作为推动AI PC的一部分,英特尔对Core Ultra谈论得更多的是,如何在AI工作负载上使NPU、CPU和GPU协同工作。通过其营销手段、与100多家软件开发商合作将更多AI加速应用推向市场,其过去几十年建立的庞大生态也是其有力的筹码。

小结

AI加速是一种高度可并行化的工作负载,在GPU上的运行速度比在通用CPU上运行得更快,这是NVIDIA抢占了先机的原因,生产式AI的流行让NVIDA更加坚定的执行AI GPU的路线。但与此同时,竞争对手们并未松懈,追赶的步伐亦步亦趋。

全部评论