到目前为止,图形处理单元(GPU)在训练和运行大AI模型方面一直占据主导地位。这些芯片最初是用来处理游戏图形的,其独特之处在于可将较高的性能、灵活性,以及可编程性集成在一起,从而能够紧跟当今AI模型日新月异的脚步。

NVIDIA在GPU市场占据主导地位,其最新市值2.96万亿美元(截至2024年9月24日)。当然,除了NVIDIA之外,AMD等公司也在生产GPU芯片。

“随着行业将精力集中于更加标准化的模型设计,将有机会构建更多在可编程性和灵活性方面要求不那么高的定制芯片。这种芯片将更加节能,而且体积更小,成本更低。”AMD首席执行官苏姿丰(Lisa Su)表示。

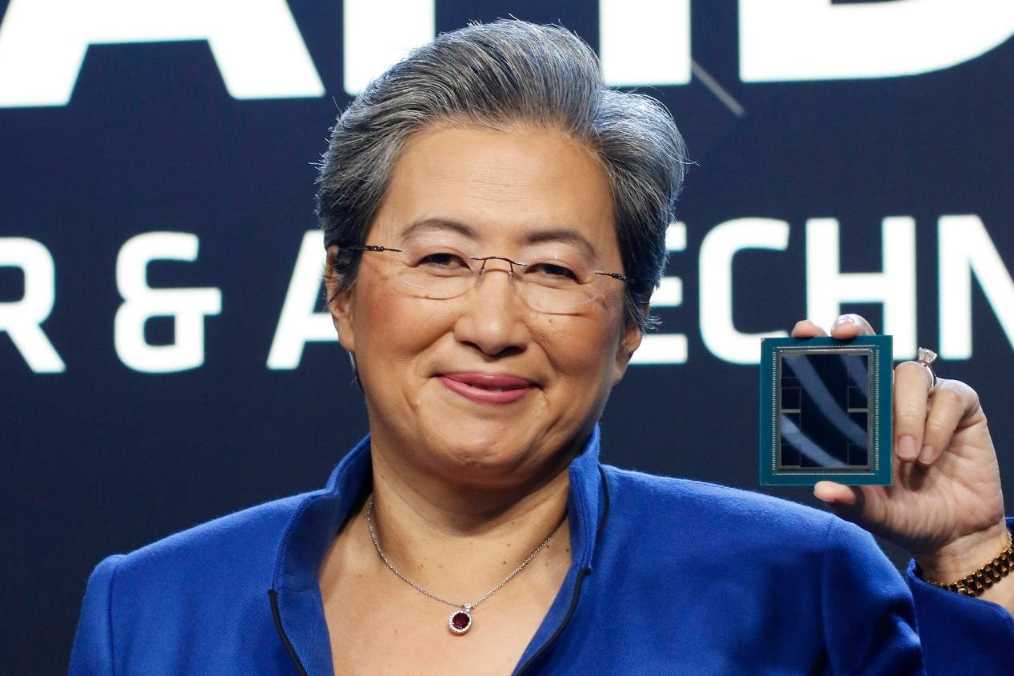

图:AMD首席执行官苏姿丰(来源:AMD)

就目前来说,GPU还是大语言模型的首选架构,因为GPU在并行处理方面非常有效,但在可编程性方面有所欠缺。苏姿丰认为五年后,GPU不一定还会是首选架构。她预计,5年,或7年时间内,GPU还不会失势,但会出现GPU以外的新势力。不过,她并没有透露AMD的具体计划。

其实已经有一些定制芯片被用于处理AI的多方面工作。

比如亚马逊和谷歌等大型云计算提供商已经开发了自己的定制AI芯片供内部使用。其中亚马逊的AWS Trainium和AWS Inferentia,以及谷歌的张量处理单元(TPU)。这些芯片只用于执行特定的功能,例如,Trainium只能训练模型,而Inferentia只进行推理。推理比训练的强度低,训练过程中,模型要处理信息,并作出响应。

博通的CEO陈福阳(Hock Tan)今年的一次内部讲话中提到,该公司定制芯片部门的季度营业利润超过了10亿美元。该部门主要帮助谷歌制造AI芯片。

IDC计算半导体研究副总裁Shane Rau表示,定制芯片在节能和成本方面具有很大优势,体积也小得多,因为它们可以在一定程度上进行硬连接:它们可以执行一项特定功能,运行一种特定类型的模型,甚至可以运行某一个特定模型。

但Rau表示,商业化销售这些超级定制化专用芯片的市场仍不成熟,这是AI模型创新令人应接不暇的一个表现。

Gartner的副总裁分析师Chirag Dekate表示,高度定制的芯片还存在灵活性和互操作性不足的问题。这种芯片非常难以编程,通常需要定制软件堆栈,而且很难让它们与其他类型的芯片协同工作。

但如今许多芯片产品都呈现出某种中间状态,一些GPU可以进行更多定制,一些专用芯片有一定程度的可编程性。这为芯片制造商带来机会,甚至是在生成式AI更加标准化之前。这也可能是个难题。

“这是我们一直在努力解决的一个大问题,”Etched联合创始人兼首席执行官Gavin Uberti说。这家初创公司生产的芯片只在Transformer架构上进行推理,该架构由谷歌在2017年开发,此后成为大语言模型的标准。尽管在一定程度上可以定制,但芯片还必须拥有足够灵活性,以适应依模型而不同的较小作业。

RISC-V主要发明人Krste Asanovic教授也曾在公开场合表示,RISC-V在AI领域也非常有优势。为此,他们还推出了针对AI应用的IP产品SiFive Inteligence,该系列在处理器设计上,采用最新的软件优先设计方法,具备高性能的矢量运算,满足人工智能与深度学习等领域各种应用的需求。X280是该系列中最新的产品,该产品已被包含谷歌在内的全球众多一线客户采用,后期这些客户也将把相关的工具、软件包、框架以及代码库开源出来惠及产业界。

AMD首席执行官苏姿丰表示,计算方面也没有万能的解决方案。未来的AI模型将使用不同类型芯片的组合,包括当今占主导地位的GPU以及仍有待开发的更专门化的芯片,以实现各种功能。

“还会有其他架构,”她说。“只是这将取决于模型的发展。”

全部评论